Зависимые и независимые случайные величины. Условные законы распределения и ковариация дискретных СВ Смотреть что такое "события случайные независимые" в других словарях

При изучении систем случайных величин всегда следует обращать внимание на степень и характер их зависимости. Эта зависимость может быть более или менее ярко выраженной, более или менее тесной. В некоторых случаях зависимость между случайными величинами может быть настолько тесной, что, зная значение одной случайной величины, можно в точности указать значение другой. В другом крайнем случае зависимость между случайными величинами является настолько слабой и отдаленной, что их можно практически считать независимыми.

Понятие о независимых случайных величинах – одно их важных понятий теории вероятностей.

Случайная величина называется независимой от случайной величины , если закон распределения величины не зависит от того, какое значение приняла величина .

Для непрерывных случайных величин условие независимости от может быть записано в виде:

![]()

при любом .

Напротив, в случае, если зависит от , то

![]() .

.

Докажем, что зависимость или независимость случайных величин всегда взаимны: если величина не зависит от .

Действительно, пусть не зависит от :

![]() . (8.5.1)

. (8.5.1)

Из формул (8.4.4) и (8.4.5) имеем:

откуда, принимая во внимание (8.5.1), получим:

![]()

что и требовалось доказать.

Так как зависимость и независимость случайных величин всегда взаимны, можно дать новое определение независимых случайных величин.

Случайные величины и называются независимыми, если закон распределения каждой из них не зависит от того, какое значение приняла другая. В противном случае величины и называются зависимыми.

Для независимых непрерывных случайных величин теорема умножения законов распределения принимает вид:

![]() , (8.5.2)

, (8.5.2)

т. е. плотность распределения системы независимых случайных величин равна произведению плотностей распределения отдельных величин, входящих в систему.

Условие (8.5.2) может рассматриваться как необходимое и достаточное условие независимости случайных величин.

Часто по самому виду функции можно заключить, что случайные величины , являются независимыми, а именно, если плотность распределения распадается на произведение двух функций, из которых одна зависит только от , другая - только от , то случайные величины независимы.

Пример. Плотность распределения системы имеет вид:

.

.

Определить, зависимы или независимы случайные величины и .

Решение. Разлагая знаменатель на множители, имеем:

.

.

Из того, что функция распалась на произведение двух функций, из которых одна зависима только от , а другая - только от , заключаем, что величины и должны быть независимы. Действительно, применяя формулы (8.4.2) и (8.4.3), имеем:

;

;

аналогично

,

,

откуда убеждаемся, что

![]()

и, следовательно, величины и независимы.

Вышеизложенный критерий суждения о зависимости или независимости случайных величин исходит из предположения, что закон распределения системы нам известен. На практике чаще бывает наоборот: закон распределения системы не известен; известны только законы распределения отдельных величин, входящих в систему, и имеются основания считать, что величины и независимы. Тогда можно написать плотность распределения системы как произведение плотностей распределения отдельных величин, входящих в систему.

Остановимся несколько подробнее на важных понятиях о «зависимости» и «независимости» случайных величин.

Понятие «независимости» случайных величин, которым мы пользуемся в теории вероятностей, несколько отличается от обычного понятия «зависимости» величин, которым мы оперируем в математике. Действительно, обычно под «зависимостью» величин подразумевают только один тип зависимости - полную, жесткую, так называемую - функциональную зависимость. Две величины и называются функционально зависимыми, если, зная значение одной из них, можно точно указать значение другой.

В теории вероятностей мы встречаемся с другим, более общим, типом зависимости - с вероятностной или «стохастической» зависимостью. Если величина связана с величиной вероятностной зависимостью, то, зная значение , нельзя указать точно значение , а можно указать только ее закон распределения, зависящий от того, какое значение приняла величина .

Вероятностная зависимость может быть более или менее тесной; по мере увеличения тесноты вероятностной зависимости она все более приближается к функциональной. Таким образом, функциональную зависимость можно рассматривать как крайний, предельный случай наиболее тесной вероятностной зависимости. Другой крайний случай - полная независимость случайных величин. Между этими двумя крайними случаями лежат все градации вероятностной зависимости - от самой сильной до самой слабой. Те физические величины, которые на практике мы считаем функционально зависимыми, в действительности связаны весьма тесной вероятностной зависимостью: при заданном значении одной из этих величин другая колеблется в столь узких пределах, что ее практически можно считать вполне определенной. С другой стороны, те величины, которые мы на практике считаем независимыми, и действительности часто находятся в некоторой взаимной зависимости, но эта зависимость настолько слаба, что ею для практических целей можно пренебречь.

Вероятностная зависимость между случайными величинами очень часто встречается на практике. Если случайные величины и находятся в вероятностной зависимости, это не означает, что с изменением величины величина изменяется вполне определенным образом; это лишь означает, что с изменением величины величина имеет тенденцию также изменяться (например, возрастать или убывать при возрастании ). Эта тенденция соблюдается лишь «в среднем», в общих чертах, и в каждом отдельном случае от нее возможны отступлении.

Рассмотрим, например, две такие случайные величины: - рост наугад взятого человека, - его вес. Очевидно, величины и находятся в определенной вероятностной зависимости; она выражается в том, что в общем люди с большим ростом имеют больший вес. Можно даже составить эмпирическую формулу, приближенно заменяющую эту вероятностную зависимость функциональной. Такова, например, общеизвестная формула, приближенно выражающая зависимость между ростом и весом.

Различают события зависимые и независимые. Два события называются независимыми, если появление одного из них не изменяет вероятность появления другого. Например, если в цехе работают две автоматические линии, по условиям производства не взаимосвязанные, то остановки этих линий являются независимыми событиями.

Несколько событий называются независимыми в совокупности , если любое из них не зависит от любого другого события и от любой комбинации остальных.

События называются зависимыми , если одно из них влияет на вероятность появления другого. Например, две производственные установки связаны единым технологическим циклом. Тогда вероятность выхода из строя одной из них зависит от того, в каком состоянии находится другая. Вероятность одного события B, вычисленная в предположении осуществления другого события A, называется условной вероятностью события Bи обозначается P{A|B}.

Условие независимости события B от события A записывают в виде P{B|A}=P{B}, а условие его зависимости - в виде P{B|A}≠P{B}.

Вероятность события в испытаниях Бернулли. Формула Пуассона.

Повторными независимыми испытаниями, испытаниями Бернулли или схемой Бернулли называются такие испытания, если при каждом испытании имеются только два исхода - появление события А или и вероятность этих событий остается неизменной для всех испытаний. Эта простая схема случайных испытаний имеет большое значение в теории вероятностей.

Наиболее известным примером испытаний Бернулли является опыт с последовательным бросанием правильной (симметричной и однородной) монеты, где событием А является выпадение, например, "герба", ("решки").

Пусть в некотором опыте вероятность события А равна P(А)=р , тогда , где р+q=1. Выполним опыт n раз, предположив, что отдельные испытания независимы, а значит исход любых из них не связан с исходами предыдущих (или последующих) испытаний. Найдем вероятность появления событий А точно k раз, скажем только в первых k испытаниях. Пусть - событие, заключающееся в том, что при n испытаниях событие А появиться точно k раз в первых испытаниях. Событие можно представить в виде

Поскольку опыты мы предположили независимыми, то

41)[стр2] Если ставить вопрос о появлении события А k-раз в n испытаниях в произвольном порядке, то событие представимо в виде

Число различных слагаемых в правой части этого равенства равно числу испытаний из n по k , поэтому вероятность событий , которую будем обозначать , равна

Последовательность событий образует полную группу независимых событий ![]() . Действительно, из независимости событий получаем

. Действительно, из независимости событий получаем

СОБЫТИЯ СЛУЧАЙНЫЕ НЕЗАВИСИМЫЕ

- такие случайные события А

и В,

для которых вероятность Р

одновременного наступления 2-х событий А к В

равна произведению вероятностей наступления каждого из них в отдельности: Р(АВ) = Р(А)·Р(В).

Аналогично определение независимости п

случайных событий. Это определение распространяется на независимость случайных величин,

а именно, случайные величины X 1 , Х 2 , ...,

Х п

независимы, если для любой группы Х i1 , X i2 , ..., X ik ,

этих величин верно равенство: Р(Х i1 ≤ х i1, Х i2 ≤ х i2 , ...,

Х ik ≤ x ik) = Р(Х i1 ≤ х i2)Р(Х i2 ≤х i2)...(Р(Х ik ≤ х ik); 1≤ k ≤ n.

При решении геол. задач методами теории вероятностей и математической статистики

корректная зависимости изучаемых величин часто является наиболее сложной и ответственной частью исследования.

Геологический словарь: в 2-х томах. - М.: Недра . Под редакцией К. Н. Паффенгольца и др. . 1978 .

Смотреть что такое "СОБЫТИЯ СЛУЧАЙНЫЕ НЕЗАВИСИМЫЕ" в других словарях:

См. События независимые случайные. Геологический словарь: в 2 х томах. М.: Недра. Под редакцией К. Н. Паффенгольца и др.. 1978 … Геологическая энциклопедия

У этого термина существуют и другие значения, см. Независимость (значения). В теории вероятностей два случайных события называются независимыми, если наступление одного из них не изменяет вероятность наступления другого. Аналогично, две случайные … Википедия

Коэффициент корреляции - (Correlation coefficient) Коэффициент корреляции это статистический показатель зависимости двух случайных величин Определение коэффициента корреляции, виды коэффициентов корреляции, свойства коэффициента корреляции, вычисление и применение… … Энциклопедия инвестора

Математическая наука, позволяющая по вероятностям одних случайных событий находить вероятности других случайных событий, связанных к. л. образом с первыми. Утверждение о том, что к. л. событие наступает с вероятностью, равной, напр., 1/2, еще не… … Математическая энциклопедия

В теории вероятностей одно из важнейших понятий этой теории. Иногда используют термины статистическая независимость, стохастическая независимость. Предположение о Н. рассматриваемых событий, испытаний и случайных величин было обычной предпосылкой … Математическая энциклопедия

Математическая наука, позволяющая по вероятностям одних случайных событий находить вероятности других случайных событий, связанных каким либо образом с первыми. Утверждение о том, что какое либо событие наступает с Вероятностью,… … Большая советская энциклопедия

ГОСТ Р 50779.10-2000: Статистические методы. Вероятность и основы статистики. Термины и определения - Терминология ГОСТ Р 50779.10 2000: Статистические методы. Вероятность и основы статистики. Термины и определения оригинал документа: 2.3. (генеральная) совокупность Множество всех рассматриваемых единиц. Примечание Для случайной величины… … Словарь-справочник терминов нормативно-технической документации

Занимается изучением событий, наступление которых достоверно неизвестно. Она позволяет судить о разумности ожидания наступления одних событий по сравнению с другими, хотя приписывание численных значений вероятностям событий часто бывает излишним… … Энциклопедия Кольера

Раздел математики, в к ром строят и изучают матем. модели случайных явлении. Случайность присуща в той или иной степени подавляющему большинству протекающих в природе процессов. Обычно она присутствует там, где существ. влияние на ход процесса… … Физическая энциклопедия

В математической статистике статистический метод, предназначенный для выявления влияния отдельных факторов на результат эксперимента, а также для последующего планирования аналогичных экспериментов. Первоначально Д. а. был предложен Р. Фишером… … Математическая энциклопедия

При изучении систем случайных величин всегда следует обращать внимание на степень и характер их зависимости. Эта зависимость может быть более или менее тесной.

Понятие о независимых случайных величинах -- одно из важных понятий теории вероятностей.

Определение 1. Случайная величина Y называется независимой от случайной величины X, если закон распределения величины Y не зависит от того, какое значение приняла величина X.

Для непрерывных случайных величин условие независимости Y от X может быть записано в виде:

Напротив, в случае, если Y зависит от X, то

Докажем, что зависимость или независимость случайных величин всегда взаимны: если величина Y не зависит от X, то и величина X не зависит от Y.

Действительно, пусть Y не зависит от X , тогда

Плотность совместного распределения согласно (5.4.5) и (5.4.6) можно записать

откуда, получим:

что и требовалось доказать.

Так как зависимость и независимость случайных величин всегда взаимны, можно дать новое определение независимых случайных величин.

Определение 2. Случайные величины X и Y называются независимыми, если закон распределения каждой из них не зависит от того, какое значение приняла другая. В противном случае величины X и Y называются зависимыми.

Для независимых непрерывных случайных величин теорема умножения законов распределения принимает вид:

т.е. плотность распределения системы независимых случайных величин равна произведению плотностей распределения отдельных величин, входящих в систему.

Остановимся, несколько подробнее на важных понятиях о «зависимости» и «независимости» случайных величин.

Понятие «зависимости» случайных величин, которым мы пользуемся в теории вероятностей, несколько отличается от обычного понятия «зависимости» величин, которым мы оперируем в математике. Действительно, обычно под «зависимостью» величин подразумевают только один тип зависимости--полную, жесткую, так называемую функциональную зависимость. Две величины X и Y называются функционально зависимыми, если, зная значение одной из них, можно точно указать значение другой.

В теории вероятностей мы встречаемся с другим, более общим, типом зависимости -- с вероятностной или «стохастической» зависимостью. Если величина Y связана с величиной X вероятностной зависимостью, то, зная значение X, нельзя указать точно значение Y, а можно указать только ее закон распределения, зависящий от того, какое значение приняла величина X.

Вероятностная зависимость между случайными величинами очень часто встречается на практике. Если случайные величины X и Y находятся в вероятностной зависимости, это не означает, что с изменением величины X величина Y изменяется вполне определенным образом; это лишь означает, что с изменением величины X величина Y имеет тенденцию также изменяться (например, возрастать или убывать при возрастании X).

Рассмотрим, например, две такие случайные величины: X -- рост наугад взятого человека, Y -- его вес. Очевидно, величины X и Y находятся в определенной вероятностной зависимости; она выражается в том, что в общем люди с большим ростом имеют больший вес.

Условные законы распределения. Регрессия.

Определение. Условным законом распределения одной из одномерных составляющих двумерной случайной величины (X, Y) называется ее закон распределения, вычисленный при условии, что другая составляющая приняла определенное значение (или попала в какой-то интервал). В предыдущей лекции было рассмотрено нахождение условных распределений для дискретных случайных величин. Там же приведены формулы условных вероятностей:

В случае непрерывных случайных величин необходимо определить плотности вероятности условных распределений j у (х) и j Х (y). С этой целью в приведенных формулах заменим вероятности событий их «элементами вероятности»,!

после сокращения на dx и dy получим:

![]()

т.е. условная плотность вероятности одной из одномерных составляющих двумерной случайной величины равна отношению ее совместной плотности к плотности вероятности другой составляющей. Эти соотношения записанные в виде

называются теоремой (правилом) умножения плотностей распределений.

Условные плотности j у (х) и j Х (y). обладают всеми свойствами «безусловной» плотности.

При изучении двумерных случайных величин рассматриваются числовые характеристики одномерных составляющих X и Y - математические ожидания и дисперсии. Для непрерывной случайной величины (X, Y) они определяются по формулам:

Наряду с ними рассматриваются также числовые характеристики условных распределений: условные математические ожидания M х (Y) и М у (Х) и условные дисперсии D х (Y) и D Y (X). Эти характеристики находятся по обычным формулам математически ожидания и дисперсии, в которых вместо вероятностей событий или плотностей вероятности используются условные вероятности или условные плотности вероятности.

Условное математическое ожидание случайной величины Y при X = х, т.е. M x (Y), есть функция от х, называемая функцией регрессии или просто регрессией Y по Х. Аналогично М Y (Х) называется функцией регрессии или просто регрессией X по Y. Графики этих функций называются соответственно линиями регрессии (или кривыми регрессии) Y по X или X по У.

Зависимые и независимые случайные величины.

Определение. Случайные величины X и Y называются независимыми, если их совместная функция распределения F(x,y) представляется в виде произведения функций распределений F 1 (x) и F 2 (y) этих случайных величин, т.е.

![]()

В противном случае, случайные величины Х и Y называются зависимыми.

Дифференцируя дважды равенство по аргументам х и у, получим

![]()

т.е. для независимых непрерывных случайных величин X и Y их совместная плотность j(х,у) равна произведению плотностей вероятности j 1 (х) и j 2 (у) этих случайных величин.

До сих пор мы сталкивались с понятием функциональной зависимости между переменными X и Y, когда каждому значению х одной переменной соответствовало строго определенное значение у другой. Например, зависимость между двумя случайными величинами - числом вышедших из строя единиц оборудования за определенный период времени и их стоимостью - функциональная.

В общем случае, сталкиваются с зависимостью другого типа, менее жесткой, чем функциональная.

Определение. Зависимость между двумя случайными величинами называется вероятностной (стохастической или статистической), если каждому значению одной из них соответствует определенное (условное) распределение другой.

В случае вероятностной (стохастической) зависимости нельзя, зная значение одной из них, точно определить значение другой, а можно указать лишь распределение другой величины. Например, зависимости между числом отказов оборудования и затрат на его профилактический ремонт, весом и ростом человека, затратами времени школьника на просмотр телевизионных передач и чтение книг и т.п. являются вероятностными (стохастическими).

На рис. 5.10 приведены примеры зависимых и независимых случайных величин X и Y.

Прапорщики и другие воинские звания: как они появились на самом деле Младший прапорщик в ссср

Прапорщики и другие воинские звания: как они появились на самом деле Младший прапорщик в ссср Можгинское медицинское училище министерства здравоохранения удмуртской республики Можгинское медицинское училище поступление

Можгинское медицинское училище министерства здравоохранения удмуртской республики Можгинское медицинское училище поступление Правильные многоугольники презентация к уроку по геометрии (9 класс) на тему Все о правильный многоугольник презентация

Правильные многоугольники презентация к уроку по геометрии (9 класс) на тему Все о правильный многоугольник презентация Таблица персонажи эпохи дворцовых переворотов

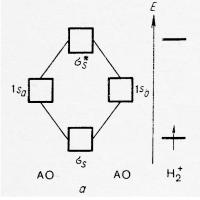

Таблица персонажи эпохи дворцовых переворотов Метод молекулярных орбиталей (ММО)

Метод молекулярных орбиталей (ММО) Герундий - примеры использования - учим испанский язык

Герундий - примеры использования - учим испанский язык Методика определения ионов кальция и магния в природных водах

Методика определения ионов кальция и магния в природных водах